- 2019-2-9

- 制御・IT系, 技術ニュース, 海外ニュース

- Artemy Kolchinsky, Brendan Tracey, ICLR 2019, MNISTデータセット, 人工知能, 深層ニューラルネットワーク, 米サンタフェ研究所

Image: Josef Steppan

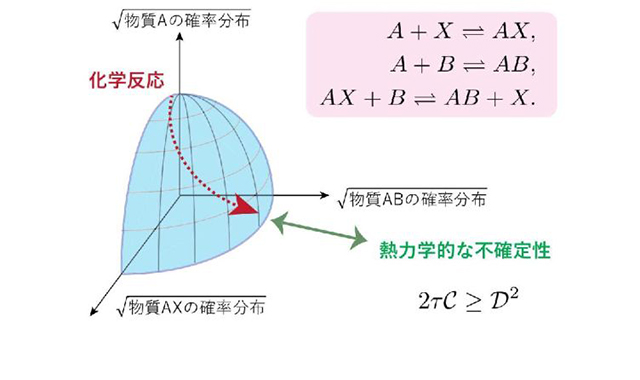

我々の社会に大きな変革をもたらす人工知能。その核心部分の深層ニューラルネットワークと呼ばれる機械学習アルゴリズムは、役に立たない情報を捨てるという能力により、膨大な生データをもとに、より普遍的な概念を学習することができる。これは例えば、様々な種類や状況にある数万枚の猫の写真を学習することで、一般的な猫の概念を得るということだ。

猫について学習する場合、多層化されたニューラルネットワークの最初の層が予測のために必要な生の情報のすべてとともに「猫」ラベルをコード化する。 その後、次の層では、猫の毛色、写り込んだミルクの受け皿のような無関係な情報は捨てられ、ボトルネックを通り抜けたかのように情報が圧縮され、普遍的な特徴だけが残される。情報理論とは、この過程における圧縮と予測のバランスに関する各層の最適性を規定するものだ。

しかし、米サンタフェ研究所の最近の研究は、この技法をありふれた分類問題(例えば、写真が猫なのか犬なのか)に適用した場合、予想外の振る舞いをすることがあることを指摘している。研究に参加したBrendan Tracey博士研究員によれば、「条件によっては、マティーニグラスをシャンパングラスに分類してしまうように、マティーニグラスをラブラドール・レトリバーと同じ分類にしてしまう」そうだ。これは、各入力に対し正しい出力が定まるような確定的シナリオにおいて、我々が簡単にできるような情報の取捨による圧縮が起こらず、ボトルネックが機能しないためだという。

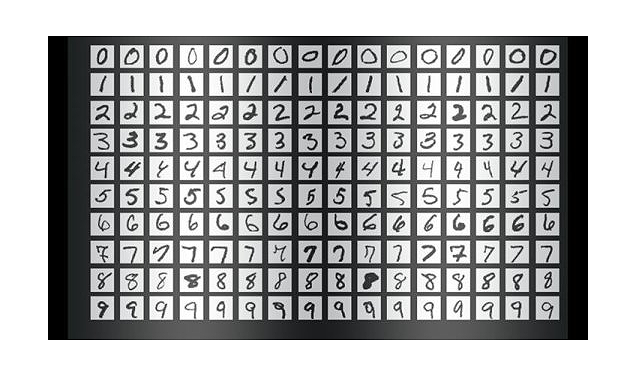

この情報ボトルネック法の注意点に関する論文は、2019年5月6日から9日まで米国ルイジアナ州ニューオリンズで開催される、機械学習に関する国際コンファレンス「ICLR 2019」に応募され、承認されている。この論文では、MNISTデータセットを使って問題が説明されている。

論文の筆頭著者であるArtemy Kolchinsky博士研究員は、「我々は、情報ボトルネック法が教師あり学習において役に立たない、と言っているわけではない。これは、よくある機械学習問題について人間の直感とは異なる振る舞いをする場合があるということで、それは機械学習コミュニティーの人々が注意を払うべきものだ」と述べている。