- 2022-9-17

- 制御・IT系, 技術ニュース, 海外ニュース

- IEEE International Conference on Robotics and Automation(ICRA) 2022, Tesla, VISTA 2.0, Waymo, インタラクティブシナリオ, オープンソース, データ駆動型シミュレーション・エンジン, ヒヤリハット, プロプライエタリーソフトウェア, マサチューセッツ工科大学(MIT), マルチエージェントシナリオ, 学術, 自律走行車(AV:Autonomous Vehicle)

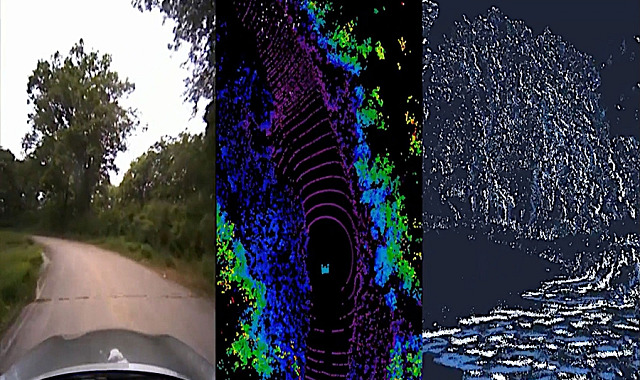

Credits:Image courtesy of MIT CSAIL.

米マサチューセッツ工科大学(MIT)は、自律走行車(AV:Autonomous Vehicle)が現実世界での運転や衝突寸前のシナリオからの回復を学習できる、データ駆動型シミュレーション・エンジン「VISTA 2.0」を開発した。この研究は、米フィラデルフィア州で2022年5月23日〜27日に開催された「IEEE International Conference on Robotics and Automation(ICRA) 2022」で発表された。VISTA 2.0のコードは全てオープンソースで公開されている。

超リアルな仮想世界は、AVにとって最高の教習所であるとされてきた。危険な運転シナリオを安全に試すために良い結果をもたらす試験台であることが証明されているためだ。「もう少しで衝突するところだった」というようなヒヤリハットのテストやそのデータ収集は、通常、簡単ではなく実際に再現することは望ましくない。そのため、米Teslaや米Waymoを含む自動運転車を開発する会社は、写真のように現実感があり、高価な独自のシミュレーターを可能にするデータに大きく依存している。

VISTA 2.0は、研究チームが以前に開発したモデル「VISTA」を基礎として作られており、既存のAVシミュレーターとは根本的に異なる。VISTA 2.0はデータ駆動型であり、現実世界のデータから構築され、まるで写真のようなリアルさでレンダリングされる点が特徴だ。そのため、修正することなくシミュレーションから現実の世界へそのまま移行が可能になる。

以前のモデルでは、1つのカメラセンサーによる単一車線追従のみをサポートしていた。しかし、高精度のデータ駆動型シミュレーションを実現するには、さまざまなセンサーと行動相互作用を合成する方法を根本から考え直す必要があった。

VISTA 2.0は、複合的センサーの種類や、膨大なインタラクティブシナリオと交差点を大規模にシミュレートできるデータ駆動型システムとなっている。研究者らは、以前のモデルよりもはるかに少ないデータでAVを訓練することができた。このようなAVは、大量の現実世界データのみで訓練したAVよりも大幅にロバストなものになる可能性がある。

VISTA 2.0は、ライブ映像だけでなく、数百万もの点群の3D LiDARデータや不規則に作動するイベントカメラのシミュレーションも可能だ。

さまざまなタイプのイベントをシミュレートでき、マルチエージェントシナリオを含むインタラクティブシナリオを作成したり、元のデータにはない新しい車両を追加したりできる。車線追従、車線変更、車両追従に加え、障害物を見てぶつからないように動く追い越しといった危険を伴うシナリオもテストした。こうして、VISTA 2.0は他の車両との双方向かつ動的なシナリオをシミュレーションする能力があることも実証した。

現在、VISTA 2.0のようなシミュレーション環境と機能を持つソフトウェアは、企業のみが占有しているプロプライエタリーソフトウェアだ。しかし、オープンソースであるVISTA 2.0リリースにより、研究コミュニティは、全自動運転向けロバスト適応制御の研究開発を加速させる強力な新しいツールにアクセスできるようになる。また、研究チームは、将来的には、他のドライバーに親しみを込めて感謝の意を表すハンドサインや会釈、パッシングのような、人間の感情のニュアンスを実装したいと考えている。

関連リンク

Researchers release open-source photorealistic simulator for autonomous driving

VISTA Driving Simulator