- 2024-7-5

- 制御・IT系, 技術ニュース, 海外ニュース

- Policy Composition(PoCo), Robotics: Science and Systems 会議, ベースライン技術, マサチューセッツ工科大学(MIT), 多目的ロボット, 学習能力, 戦略(ポリシー), 拡散モデル(生成AIの一種), 機械学習モデル, 生成AI

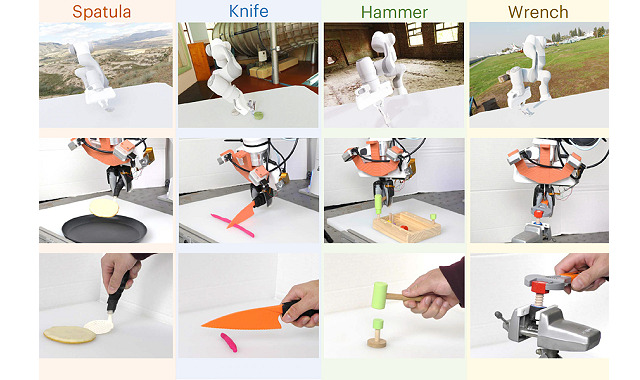

Credits:Image: Courtesy of the researchers

マサチューセッツ工科大学(MIT)は2024年6月3日、生成AIを用いて多種多様なデータを組み合わせ、多目的ロボットの学習能力を向上させる新技術「Policy Composition(PoCo)」を発表した。この研究は、同年7月15日~19日にオランダのデルフトで行われるRobotics: Science and Systems会議で報告される予定だ。

ロボットにツールの使い方を理解させるには、ツールの使用方法を示す膨大な量のデータが必要だ。しかし、ロボット向けのデータセットには、色や触覚といった幅広いモダリティや、シミュレーションか人間のデモかといったドメインなど、多様なソースがある。このようなたくさんのソースから得たデータを1つの機械学習モデルに効率的に組み込むことは難しい。そのため、1種類のデータのみを使用してロボットをトレーニングした場合に、未知の環境での新しいタスクをしばしば実行できないという問題がある。

そこでMITの研究チームは、拡散モデル(生成AIの一種)を使用して、ドメイン、モダリティ、タスクにまたがる多様なデータソースを組み合わせ、ロボットがさまざまなタスクを実行できるようにする技術「PoCo」を開発した。

まず、複数の拡散モデルを別々に訓練する。それぞれの拡散モデルは、多様なデータソースのうち、ある特定の小規模なデータセットを使って、1つのタスクを完了させるための戦略(ポリシー)を学習。画像生成AIと同様に、訓練用データセットにノイズを加えることで、これらの拡散モデルは徐々にノイズを除去し、出力を洗練させる。ただし、生成するのは画像ではなく、ロボットの軌道だ。

次に、個々の拡散モデルが学習した複数のポリシーを組み合わせて、ロボットがさまざまな環境で多様なタスクを実行できる一般的なポリシーを作り出す。

研究チームは、シミュレーションと実世界の実験でPoCoの有効性を検証した。その結果、ロボットはハンマーで釘を打ったり、ヘラで物体をひっくり返したりといった、複数のツールを使用するタスクを実行でき、訓練中に見ることのなかった新しいタスクにも適応できた。これはベースライン技術と比較して20%の性能向上となった。