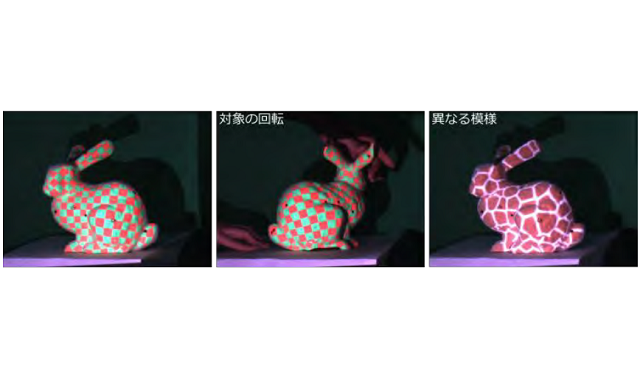

光センサーを埋め込んだ立体物へのプロジェクションマッピング

大阪大学は2017年9月25日、プロジェクションマッピングにおいて映像位置合わせを自動化するシステムを開発したと発表した。

プロジェクションマッピングでは、立体的かつ動いている対象物に映像をピッタリと合わせて投影する必要があり、これまではプロジェクターから特殊なパターンを何種類も投影したり、カメラを使って動いている対象面の位置姿勢の変化を計測したりして調整する必要があった。

今回開発した方法は、そのような特殊パターンの投影やカメラによる計測の必要が無い新しい位置合わせの技術だ。

1つ目は、対象面に光センサーを埋め込み、映像コンテンツを投影している際に、センサーに照射しているプロジェクター画素の位置を、その受光タイミングから求めることで、投影映像を対象面に位置合わせする方法だ。

2つ目は、逆に光センサーをプロジェクターに設置し、対象面からの投影コンテンツの反射光を逐次計測。プロジェクター画素と対象面の模様との位置対応を求める。これにより、従来の画像マーカーを用いたカメラ計測による位置合わせが、カメラなしでも行えることを明らかにした。

これらの技術はさまざまな形態のプロジェクションマッピング適用することができる。また、3次元物体のさまざまな面の模様を自在に変更したり、光センサーを埋め込んだIoT型のペンでインタラクティブなお絵かきをしたり、レーザープロジェクターを搭載した映像投射型ドローンからの投影映像の位置合わせなどへの応用例が考えられる。