- 2019-1-13

- 技術ニュース, 海外ニュース, 電気・電子系

- Duygu Kuzum, Nature Communications, soft-pruning, spiking neural network, カリフォルニア大学サンディエゴ校(UCSD), サブ量子CBRAM(Conductive Bridging RAM), ニューラルネットワーク, メモリ開発企業アデスト(Adesto Technologies), 学術

カリフォルニア大学サンディエゴ校(UCSD)の研究チームは、高効率、高速なニューラルネットワークによる学習を実現するため、消費電力を最大で1000分1に減らせる新たなハードウェアとアルゴリズムを開発した。将来的には、スマートフォンや組み込み機器など低消費電力デバイスでのニューラルネットワーキングの実現を狙う。研究成果は、2018年12月14日発行の『Nature Communications』誌に掲載されている。

一般的に、ニューラルネットワークが物体の認識や自動運転などの高度なタスクを処理できるように学習させるには多くの電力と時間が必要だ。そのトレーニングには数百から数千のプロセッサというコンピューターネットワークを使っても数週間から数カ月かかり、その大半はメモリとプロセッサの間でデータのやり取りに消費されている。この問題を解決するため、UCSDのDuygu Kuzum教授率いる研究チームは、メモリ開発企業アデスト(Adesto Technologies)と共同で、プロセッサなしでメモリだけでニューラルネットワークによる全学習を実行可能にするためのハードウェアとアルゴリズムの開発に取り組んだ。

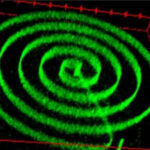

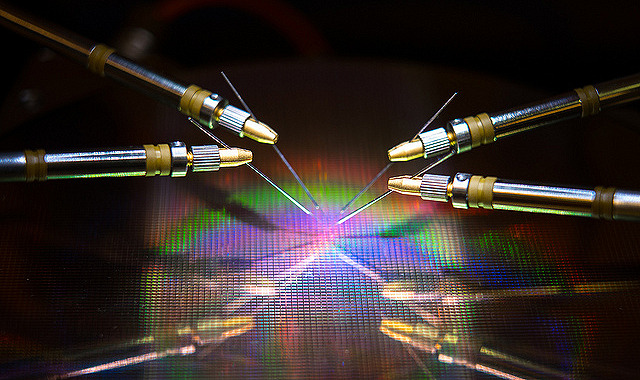

Kuzum教授らの開発したハードウェアは、512kbのサブ量子CBRAM(Conductive Bridging RAM)。このメモリはアデストの持つ抵抗変化メモリCBRAM技術をベースに、0と1というビット情報ではなく、人間の脳のシナプスを模倣するよう多様なアナログ状態を扱えるようにしたものだ。

そしてKuzum教授らは、開発したサブ量子CBRAMで構成するニューラルネットワーク「spiking neural network」を開発し、教師なし学習の「重み」の更新を効率化するためのアルゴリズム「soft-pruning」を開発した。pruningとは重みを取り除く技術のことである。

ニューラルネットワークでは、入力層と出力層のニューロン同士の結びつきの強さは重みで表される。従来のニューラルネットワークでは、重みを一つ一つ継続的に更新するのに多大なエネルギーがかかっていた。だが、Spiking neural networksでは、Spiking neuronと結びついた重みだけが更新される。そのため、アップデート回数が少なくなり、コンピューティングの電力と時間が減少する。

研究チームは、開発したCBRAMにSpiking neural networksとsoft-pruningを組み合わせ、MNISTデータベース上の手書き数字を分類させるテストを行った。75%の重みが取り除かれた場合でも、93%もの精度が発揮された。従来の技術で同じタスクを行うと、40%重みを取り除いただけで、精度は90%以下に落ちる。Kuzum教授は「超低消費電力メモリであるCBRAMによって消費電力を10~100分の1に、アルゴリズムでさらに10分の1に削減できる。合計100~1000分の1まで、電力削減が可能だ」と語る。

Kuzum教授は、「現行のプロセッサのオンチップメモリの機能は制限されており、同一チップ上でコンピューティングとストレージを同時に実行する能力がない。だが今回開発した手法により、外部プロセッサへのデータ転送せずにメモリのみでニューラルネットワークによる学習を行うことが可能になる」と、その成果を説明している。

関連リンク

Hardware-software co-design approach could make neural networks less power hungry