- 2023-5-16

- 技術ニュース, 機械系, 海外ニュース

- AI, CADアプリ, EchoSpeech, Ruidong Zhang, クラウド, コーネル大学, スタイラス, スマートデバイス, スマートフォン, スマートメガネ, 学術, 無発声音声入力, 非接触型センサー, 音声合成装置, 音響センシングシステム, 騒音

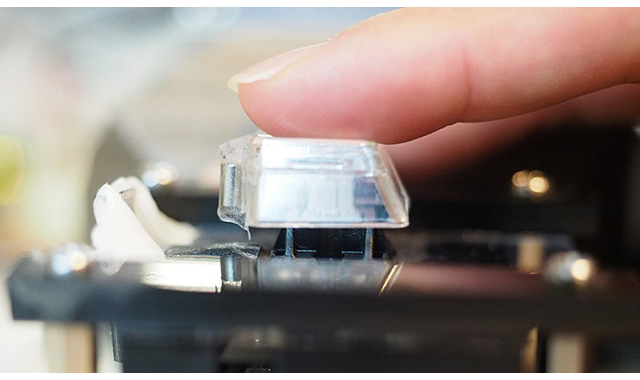

イメージ画像

スマートフォンやスマートデバイスなど音声で操作できるデバイスが増えているが、静かな職場や公共の場所での利用には、周囲への気遣いが必要だ。また、逆に騒音がある環境では、話者の音声が騒音に紛れてうまく検知できないこともある。

今回、米コーネル大学の研究チームは、無発声でも口元の動きや喉の動きを感知して音声に変換する「無発声音声入力」によって、無発声のコミュニケーションを可能にする新しい技術を開発した。「EchoSpeech」と名付けられたこのスマートメガネは、小型のペアマイクとスピーカーを使って、着用者の顔面の動きをソナーのように音響反射から読み取ってAIによる解析を加えることで、機械的な入力を必要とせず、さまざまな音声入力による作業指示が可能だ。この技術は、コーネル大学の博士課程に在籍するRuidong Zhang氏が開発したものだ。

同氏によると、開発した音響センシングシステムは、電力効率に優れ、非接触型センサーとして静電容量方式や距離検知方式よりも検知範囲や分解能が優れている。コストも安く、ウェアラブルデバイスで広く利用可能だ。センシングには、人に聞こえにくい18kHz以上の音響信号のみを使用しているという。

取得したデータはクラウドにアップロードされるのではなく、スマートフォンでローカル処理されるため、プライバシーに関わる情報が流出することはない。また、バッテリー作動時間は10時間で、カメラによる画像認識システムの30分から飛躍的に向上したという。

チームによると、EchoSpeechは騒がしいレストランや静かな図書館など、発声が不適切な場所で、スマートフォンを使ったコミュニケーションに有用だという。また、スタイラスと組み合わせることで、キーボードやマウスなしでCADアプリを使うこともできるとしている。さらに発音に障害のある人がこの技術を使うことで、音声合成装置が読み取った言葉を本人に代わって再生することも可能だという。

研究チームは、コーネル大学の資金提供プログラムを利用して、この技術の商業化を検討している。また、顔、目、上半身の動きを追跡するスマートメガネの開発も検討しているという。

関連情報

AI-equipped eyeglasses can read silent speech | Cornell Chronicle