- 2024-2-20

- 制御・IT系, 技術ニュース, 海外ニュース

- AIアルゴリズム, arXiv, ChatGPT, LLM(大規模言語モデル), Mamba, Mamba-3B, Transformer, スループット(推論速度), プレプリントサーバー, モダリティ(情報種別), リニアスケーリング, 入力データ(シーケンス), 深層学習モデル, 生成AIチャットボット

新たなAIアルゴリズム「Mamba」の開発成果とされる論文が、2023年12月1日、プレプリントサーバー「arXiv」に掲載された。論文は、Mambaの性能について、ChatGPTを駆動するLLM(大規模言語モデル)の「Transformer」より5倍高速だと主張している。

Transformerは、生成AIチャットボットの基盤技術であり、用途の広い深層学習モデルだ。ただし、Transformerには、入力データ(シーケンス)が長い場合に計算の効率が低下するという弱点があった。

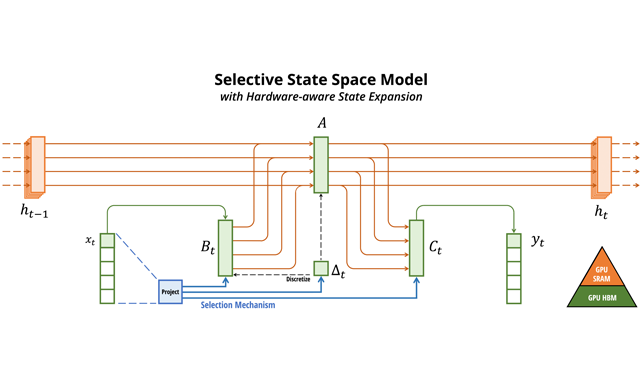

Mambaの技術的な特徴は、構造化された状態空間モデル(SSM)を改良したことで、モデルのパラメータを、入力データに合わせて動的に調整する能力だ。これにより、データの重要な部分の処理に集中し、不要な情報は無視できる。

論文は、Mambaのスループット(推論速度)が、Transformerより5倍高速だと説明している。処理時間でいえば、入力データの長さに比例するリニアスケーリングを達成しており、非常に長い入力に対しても、現実的な時間内に処理を完了する。実際、最大100万トークンのシーケンスを持つ実データで、性能の向上が確認された。

Mambaは、言語、音声、ゲノム解析など、様々なモダリティ(情報種別)に対して、最先端の性能を達成していると著者らは主張している。

「Mamba-3B」モデルは事前学習と下流評価の双方において、2倍の規模のTransformerの性能に匹敵すると、論文は説明している。