- 2020-1-6

- 制御・IT系, 技術ニュース, 海外ニュース

- 2D画像, 3Dプロパティ, 3Dモデル, AI, DIB-R, NVIDIA, エンコーダ・デコーダアーキテクチャ, ティラノサウルス, ロボット工学, 微分可能な内挿ベースのレンダラー(differentiable interpolation-based renderer), 自律型ロボット

写真を撮るだけで、奥行きや質感を立体で再現できるかもしれない。NVIDIAの研究チームは、2D画像から3Dモデルを生成するAIを開発した。ティラノサウルスなどすでに絶滅した動物も、画像があれば1秒たらずでリアルな3Dモデルにすることができる。研究結果は、カナダのバンクーバーで開催された「神経情報処理システム(NeurIPS)」の年会で発表された。

研究チームが開発したAIは、「微分可能な内挿ベースのレンダラー(differentiable interpolation-based renderer)」、略して「DIB-R」と呼ばれるものだ。DIB-Rは、エンコーダ・デコーダアーキテクチャを利用して、2D画像から物体の形や色、質感やライティングといった3Dプロパティを予測し、忠実度の高いレンダリングを作成する。

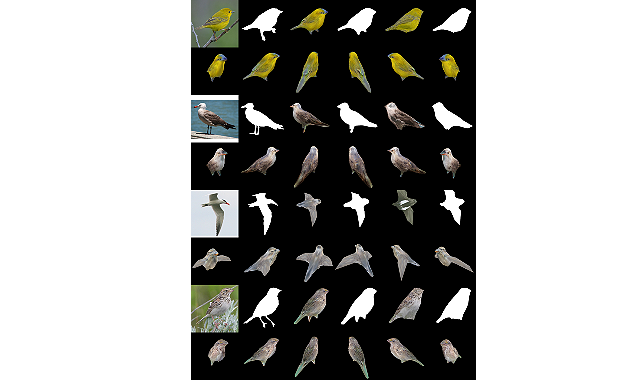

例えば、あらかじめ鳥のデータセットで学習しておけば、1枚の鳥の2D画像からでも実際の鳥の質感と形状を再現した3Dモデルが得られる。動作も速く、100ミリ秒以内で2Dから3Dへ変換できるという。

DIB-Rは3Dモデルの生成だけでなく、ロボット工学においても有効だ。自律型ロボットにとっては、周辺のものを検知し認識することが重要だが、DIB-Rを利用することで、奥行き方向の認知機能を改善できるとしている。

関連リンク

2D or Not 2D: NVIDIA Researchers Bring Images to Life with AI