- 2021-2-7

- 制御・IT系, 技術ニュース, 海外ニュース

- Alexa, Earable computhing, Siri, イヤホン, イリノイ大学CSL(Coordinated Science Laboratory), システムネットワーキング研究グループ(SyNRG:Systems and Networking Research Group), モーションセンシング, 学術, 拡張現実(AR), 第26回Annual International Conference on Mobile Computing and Networking(MobiCom2020)

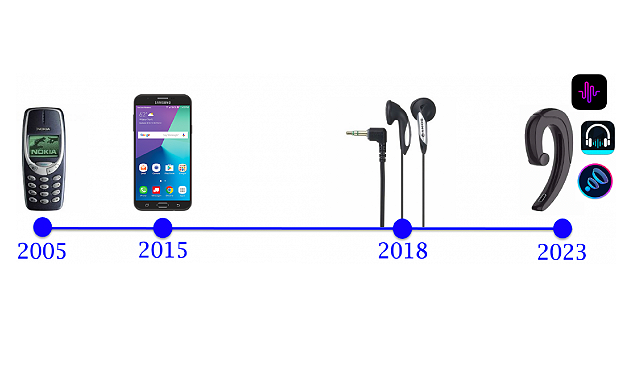

イリノイ大学CSL(Coordinated Science Laboratory)のシステムネットワーキング研究グループ(SyNRG:Systems and Networking Research Group)は、「Earable computing」と呼ぶモバイル技術の新しいサブ領域を提唱している。イヤホンが今後のウェアラブルデバイス開発に極めて重要であり、ハードウェア、ソフトウェア、アプリがすべてイヤホン型コンピュータ上で機能するようになると研究グループは考えている。

研究グループは、通話を目的とした電話がスマートフォンに変革したように、イヤホンが音を聞くための電子機器の付属品からイヤホン型コンピュータに飛躍すると述べている。将来的にイヤホンは、人間の行動の継続的な感知、音の拡張現実(AR)の実現、AlexaやSiriによるジャストインタイムの情報伝達、ユーザーの動作や健康状態の追跡、シームレスなセキュリティの提供などをするようになるという。

Earable computingでは、センシング、信号処理、組込みシステム、通信、機械学習など、幅広い分野が研究対象となる。SyNRGはアルゴリズムの開発とともに、実際のイヤホン型プラットフォームのユーザー試験を実施している。最近では、2020年にロンドンで開催された「第26回Annual International Conference on Mobile Computing and Networking(MobiCom2020)」で、顔のモーションセンシング、音のAR、イヤホンの音声定位という異なる分野における3本の論文を発表している。

顔のモーションセンシングの研究では、歯の動きにより生じる振動をイヤホンが感知して、6種の“歯によるジェスチャー”を検出することに成功している。この技術により、手を使わないスマートフォン操作も可能になるだろう。またイヤホン装着中の歯ぎしりを感知することも可能だという。将来的には、イヤホンを用いて顔の筋肉の動きや感情を分析することも視野に入れている。

音のARは、屋内における音声ガイドとして利用できる。イヤホンが屋内にある目的地の相対的な位置を推定し、目的地の方向からガイドする3D音声がイヤホンを通して聞こえてくる。イヤホンの音声定位の論文では、近くの壁の反射を利用した音の方向の検出を報告している。つまり、イヤホンが自動で音が聞こえてくる方向をチューニングするようになる。

研究グループは、自分たちは10年前からモバイルセンシングとコンピューティングに取り組んでおり、Earable computingという新興領域を定義するにふさわしい多くの経験を持つと述べている。