- 2022-4-28

- 制御・IT系, 技術ニュース, 海外ニュース

- EyeSyn, International Conference on Information Processing in Sensor Networks(IPSN) 2022, デューク大学, メタバース, 仮想現実(VR), 学術, 拡張現実(AR), 眼球運動データ

米デューク大学は、人間の実際の眼球運動データを収集しなくても、仮想現実(VR)や拡張現実(AR)のプログラムを訓練するには十分なほど人間の目の動きを正確にシミュレートする「EyeSyn」プログラムを開発したと発表した。この研究の詳細は、2022年5月4日〜6日にオンラインで開催されるセンサーネットワークに関する国際会議「International Conference on Information Processing in Sensor Networks(IPSN) 2022」で発表される予定だ。

眼球運動データは、メタバース内のプラットフォームやソフトウェアを開発する企業にとって、計り知れない価値のあるものだ。しかし、人間の眼球がどう動いているかについてのデータを収集するのは、骨の折れる作業だ。

例えば、目だけに注目して、その人が漫画を読んでいるのか高度な文学を読んでいるのかを検出することは可能だが、検出アルゴリズムを訓練するには、何時間もヘッドセットを装着した何百人もの人からデータを取得する必要がある。小規模な企業はそのようなレベルのリソースを持ってはいない。

さらに、目の動きによって、性的偏見や人種的な偏見、他人に知られたくない興味、そして自分自身ですら知らないかもしれない情報を、意図せずに明らかにしてしまう可能性があるという問題もある。

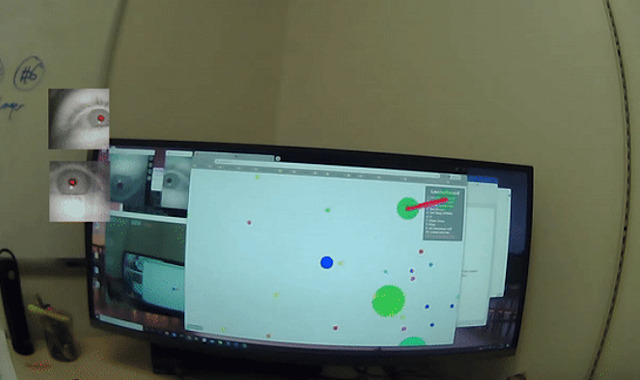

そこで研究チームは、実際の人間の眼球運動データなしで、人間が世界をどのように見ているかを正確にシミュレートできる「バーチャルの目」ともいえる「EyeSyn」を開発した。

研究チームはまず、人間がどのように視覚情報を処理するかを研究した認知科学の文献を調べた。例えば、人が話しているのを見ているとき、視線は相手の目、鼻、口の間を移動するが、その移動時間はさまざまだ。EyeSynを開発する際、研究チームは話者の目、鼻、口がどこにあるかを抽出するモデルを作成し、各部位に集中している時間を統計的にエミュレートするようにプログラムした。

EyeSynにさまざまなデータを入力して十分な回数を実行すれば、新しいプログラム用の機械学習分類器を訓練するには十分な量の、人工的な眼球運動のデータセットを作成できる。

研究チームは、この人工的な眼球運動の精度を検証するため、一般に公開されているデータを利用した。まず、ある動画を「視聴」させて得たデータを、同じ動画を見た人間の目の動きのデータと比較した。さらに、人工の「目」で美術品を見る仮想のデータセットと、バーチャル美術館を閲覧する人々から収集した実際のデータセットとを比較した。その結果、EyeSynは実際の視線シグナルの明確なパターンと厳密に一致しており、人によって異なる目の反応をシミュレートできることが分かった。

これは、新しいメタバースプラットフォームやソフトウェアを訓練するためのベースラインとして企業が使用するには十分な性能だという。また、眼球運動データ収集に伴うプライバシーに対する懸念を軽減するだけでなく、小規模企業でもメタバースゲームに参入できるようになる。

研究チームは、人工的なデータだけでは完璧ではないが、特定のユーザー向けにアルゴリズムをパーソナライズすればさらに良い結果を得ることもできるとしている。

関連リンク

Simulated Human Eye Movement Aims to Train Metaverse Platforms

EyeSyn: Psychology-inspired Eye Movement Synthesis for Gaze-based Activity Recognition