同技術における適用例

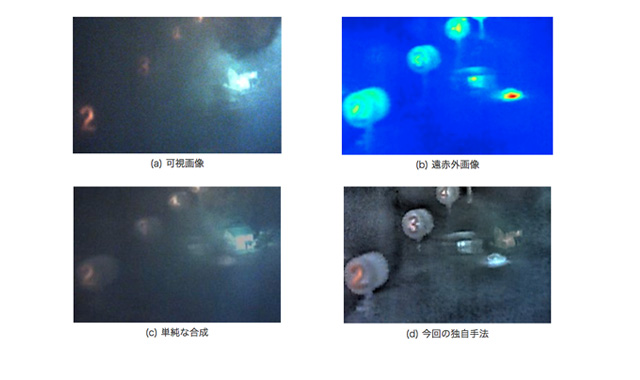

NECと東京工業大学工学院の奥富正敏教授らの研究グループは2017年6月5日、一般カメラで撮影した可視光画像と、サーモカメラなどで撮影した非可視光画像を、AIを用いて自動的かつ効果的に合成し、それぞれの画像単独では捉えにくかった対象物/状況の視認性を高める「マルチモーダル画像融合技術」を共同開発したと発表した。

画像センサの技術的な進化や低コスト化により、サーモカメラやX線/テラヘルツ波/ミリ波のカメラなどの非可視光カメラを利用して、悪天候や悪条件下でも監視や診断を行う用途が広まってきている。しかし可視光に比べ解像度や画質が低く、視認性が悪いため、可視光カメラの画像と合成する作業を専門家が手動で行うといった対応が必要となっていた。

今回開発された技術は、専門家の画像変換ノウハウを学習したAIを用いて可視光カメラと非可視光カメラの画像を自動的かつ効果的に統合するもの。視認性を格段に高め、劣悪な環境でも素早く異常や危険物の有無の判断を可能にする。

サーモカメラやテラヘルツカメラといったカメラの種類や、環境の特性(明るさ、光線の方向、障害物の有無など)に応じて、AIが画像内の各部分の視認性の度合いを評価し、各画像から最適な領域のみを自動的に抽出。さらに、非可視カメラの画像中の異常や危険物などの特徴をAIが解析し、白とびや黒潰れなどの画像破たんのない適切な強調度合いを判断して、高い視認性を持つ融合画像を自動的に生成する。

今回の技術により、瞬時の視認が必要となる様々な分野で、悪条件下でも正しい状況判断が可能になる。例えば、夜間や濃霧などの悪天候下の施設監視、対向車のヘッドライトや暗闇による死角があっても運用できる自動運転支援、建物内部の異常まで検査可能にするインフラ点検などに活用が可能だという。