- 2019-4-29

- 制御・IT系, 技術ニュース, 海外ニュース

- AADS(Augmented Autonomous Driving Simulation )システム, Baidu Research, Dinesh Manocha, LiDAR, Science Robotics, ポイントクラウド, メリーランド大学, 学術, 自動運転シミュレーター, 香港大学

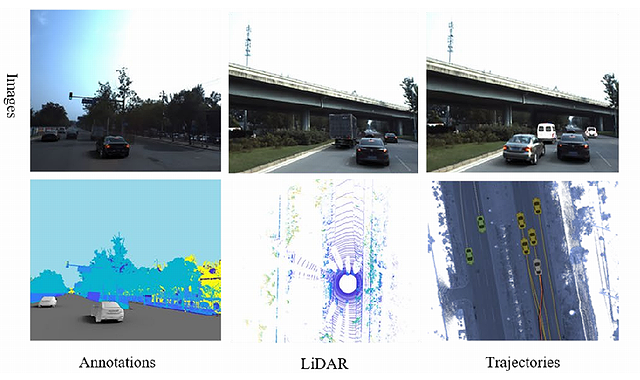

メリーランド大学のDinesh Manocha教授は、Baidu Researchと香港大学の研究者と共同で、写真やビデオ、LIDARデータから現実の世界を如実に再現し、社会科学的な手法によって歩行者や車両の行動パターンを予測する自動運転シミュレーター「AADS(Augmented Autonomous Driving Simulation )システム」を開発した。研究成果は2019年3月27日付『Science Robotics』誌に公開されている。

自動運転車の開発では、テスト走行の前にシミュレーターで事前評価を行うが、既存の手法として、コンピューターグラフィックス(CG)と数学的にモデル化された交通パターンを用いてシミュレーションを行うのが一般的だ。しかし、リアルな環境を描き、現実世界の人や自動車の行動パターンを再現するのは難しい。

今回研究チームが開発したAADSシステムは、写真やビデオ、LIDARで収集したポイントクラウドを用い、現実世界を写実的に再現したシミュレーション環境を構築できる。それと同時に、その写真やビデオから抽出した歩行者や自転車の軌道データを駆使し、自分以外の他の車両や歩行者の将来の位置を予測することが可能だ。

開発者のManocha教授は、「AADSシステムでは、ビデオや写真を使って、現実の世界を再現するとともに、人や車の実際の行動パターンも把握する。人間の運転行動を数学モデルや物理学の法則で捉えるのは容易ではない。そのため、利用可能な全てのビデオから実際の軌道データを抽出し、社会科学的手法によってモデル化した」と、説明する。

写真やビデオをシミュレーションに使用するためには、乗り越えなければならない壁がある。シミュレーションにおいては、走行する自動運転車の背景を構成するあらゆる要素が、実際には自動運転車に設置されたカメラから撮った映像ではなくても、まるで自動運転車から見た景色であるかのように、自動運転車の動きに合わせて変化しなければならない。

そこでManocha教授らは、人や車両などとその背景とを分離させ、それぞれ個々の独立の要素とする技術を開発した。AADSシステムにおいては、背景を含むさまざまな要素が予測技術に基づいてあらゆる視点から素描されている。そのため、車線変更や方向転換のシミュレーションの際、自動運転車の動きと背景の対応がスムーズで、従来のシミュレーターに比べてゆがみが生じにくいという。

さらに、AADSを使用すると、車両や歩行者をある背景から取り出して、全く別の背景のもとで再合成できる。交通レベルも元のレベルと異なったパターンで再現できるので、多様なシナリオのもとで自動運転の安全性を評価できるとしている。

関連リンク

AADS: Augmented autonomous driving simulation using data-driven algorithms