- 2021-1-7

- 制御・IT系, 技術ニュース, 海外ニュース

- AI, Ampere, BERT -Large, GPU, HP, Lenovo, NVIDIA, NVIDIA A100, NVIDIA A100 80GB GPU, NVIDIA DGX Station A100, デル, 富士通, 高性能計算(HPC)

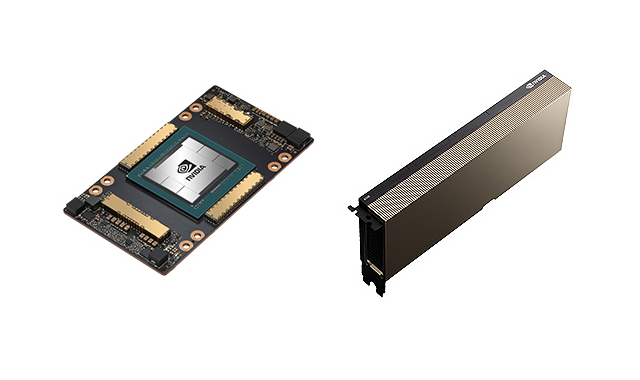

NVIDIAは、2020年11月16日、同社の「Ampere」アーキテクチャーをベースとした初のGPUである「NVIDIA A100」の40GB高帯域幅メモリを、80GBに倍増した「NVIDIA A100 80GB GPU」を発表した。A100 80GB GPUはHBM2e技術を搭載しており、業界で初めて毎秒2テラバイトを超えるメモリ帯域幅を可能にした。

高性能計算(HPC)やAIの研究には、ますます大きなモデルの構築が求められるようになっているが、それには非常に多くのメモリ容量と帯域幅が必要だ。A100 80GB GPUを用いることで、データの読み込みが速くなるため、アプリケーションを大幅に高速化し、これまでにない規模のモデルやデータセットに挑戦できるようになる。例えば、DLRMのようなレコメンダーシステムモデルでは、何十億人ものユーザーと何億もの製品データを含むテーブルがあるが、A100 80GBは最大3倍高速化できるので、モデルを素早く再トレーニングできるようになり、ユーザーに適した製品を非常に正確に薦めることができるようになる。

デル、HP、Lenovo、富士通など複数のトップ企業が、同GPUを4台あるいは8台搭載したHGX A100 統合ベースボードを使って構築したシステムを、2021年上半期に提供開始する予定だ。

また、同時に、世界唯一のペタスケール統合型AIワークグループサーバーで、2.5PFLOPSのAI性能を持つ「NVIDIA DGX Station A100」も発表された。A100 Tensor コア GPU4基(80GBまたは40GB)と最大320GBのGPUメモリを搭載している。

DGX Station A100は、AIデータセンターの機能と性能をワンボックスで提供するもので、データセンターのような電力または冷却性能を必要としない。企業のオフィスや研究施設、自宅のホームオフィスなど、あらゆる場所に組み込むことができ、データセンター以外でもAIの活用を可能にする。

BERT -Largeの推論のような複雑な対話型AIモデルに対応するために、処理速度は前世代のDGX Stationから4倍以上速くなった。また、BERT-LargeのAIトレーニングのための性能は3倍近く向上している。

さらに、新しい「NVIDIA DGX A100 640GB」システムでは、DGX A100システムに新しいA100 80GB GPUを搭載でき、システム当たりのGPUメモリ容量が640GBへと倍増した。DGX Station A100、DGX A100 640GBともに、2020年年末までに発売される予定だ。

関連リンク

NVIDIA、メモリを倍増したA100 80GB GPU を発表、世界で最も強力な AI スーパーコンピューティング用 GPU を大幅に強化

NVIDIA DGX Station A100 は、研究者にAI データセンターの機能と性能をワンボックスで提供