- 2024-4-25

- 制御・IT系, 製品ニュース

- cotomi, cotomi Light, cotomi Pro, ELYZA Tasks 100, GPT-4, Japanese MT-Bench, LLM, NEC, 大規模言語モデル, 生成AI

NECは2024年4月24日、LLM(大規模言語モデル)「cotomi Pro」と「cotomi Light」を発表した。LLM「cotomi」の学習データやアーキテクチャを刷新している。

cotomi Proとcotomi Lightは、高速、高性能なモデルで、グローバルのLLMと同等の高い性能を十数倍の速度で提供する。LLMの性能を高めるためには、一般的にモデルを大規模にする必要があり、動作速度が遅くなるが、学習方式やアーキテクチャの工夫により、速度と性能を両立している。

また、同社グループでは、約4万人の社員が約1年、生成AIの社内サービスを社内業務に活用しているため、現実的なユースケースでの性能も大幅に向上している。

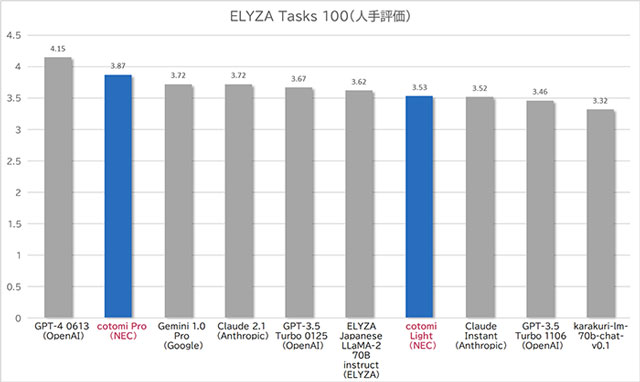

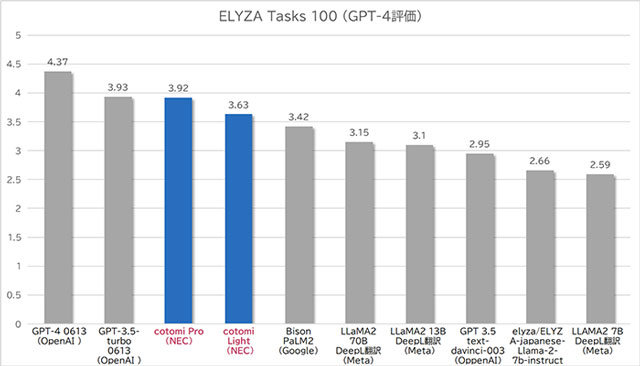

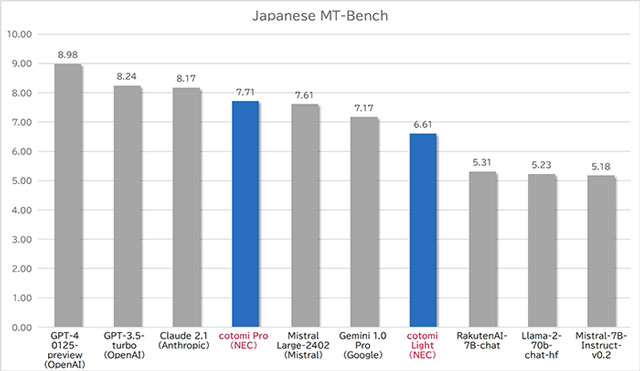

文書要約、論理推論、質問応答など様々なタスクを処理する能力、知識量は、LLMの総合的な性能の測定によく用いられる「ELYZA Tasks 100」「Japanese MT-Bench」の2つのベンチマークによる評価で、グローバルでもトップレベルとなる性能を確認している。

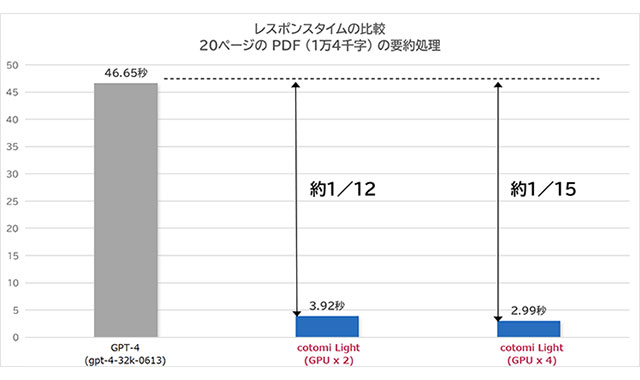

cotomi Proは、GPU2枚の標準的なサーバーでGPT-4比5倍以上の速度を有しながら、Gemini 1.0 Proなどのモデルを上回ってClaude 2からGPT-4に比肩する性能を示している。cotomi Lightは、GPT-4比で15倍以上とさらに高速でありながら、LLaMA2-70Bなどの巨大なモデルの性能を上回ってGPT-3.5-Turboなどに比肩する性能を示している。

cotomi Proとcotomi Lightは、標準的なGPU2枚で、クラウド環境でのGPT-4使用時と比較して、8分の1~15分の1の時間で処理する高速性を有する。また、同時アクセス数の拡大、ファインチューニングに必要な学習時間も短縮している。速度は、GPUを4枚、8枚と増強することでさらに向上できる。

今回開発したcotomi Proとcotomi Lightは、生成AIを活用した業務アプリケーションのレスポンス時間を大幅に縮め、ユーザー体験を向上できることに加え、企業ごとの個別データでのファインチューニング後の性能を大幅に高めることにも繋がる。

関連情報

NEC、世界トップレベル性能の高速な大規模言語モデル (LLM) cotomi Pro / cotomi Light を開発 (2024年4月24日): プレスリリース | NEC