- 2020-7-30

- 制御・IT系, 研究・技術紹介

- AI, Deep Neural Network, DNN, DRIVE Hyperion, GaN, GPU, NVIDIA, NVIDIA DRIVE, カンブリア爆発, コンピュータビジョン(CV), ニューラルネットワーク, 敵対的生成ネットワーク, 画像認識, 自動運転

NVIDIA シニアソリューションアーキテクト 室河徹氏

自動車業界で加速する自動運転開発において、ドライバーの代わりに周囲を認識する画像認識は、安全性を保障するために欠かせないコア技術です。より速く、より正確に物体を認識するため、ニューラルネットワークを使った画像認識システムが使われています。

今回の連載では、NVIDIA シニアソリューションアーキテクト 室河徹氏にお話を伺い、AI関連技術の急速な発展を支えるGPU(Graphics Processing Unit:画像処理に特化した演算装置)やニューラルネットワークについて、自動運転車開発の切り口で紹介していきます。第2回目となる今回は、「ニューラルネットワークと自動運転」です。(執筆:後藤銀河)

第1回目:GPUが加速するAI開発。AIの発展に必要な3つの要素とは?――NVIDIA 室河徹氏

――前回、古生代に見られたカンブリア爆発のように、多様なニューラルネットワークが登場していると伺いました。特に注目を集めているニューラルネットワークには、どのようなものがあるのでしょうか?

[室河氏]GAN(Generative Adversarial Networks)と呼ばれる敵対的生成ネットワークなどが注目されています。GANでは二つのニューラルネットワークを使いますが、一つは人間の顔に似せた画像を作って反対側のニューラルネットワークを騙そうとします。それに対して、反対側のニューラルネットワークは騙されないよう、本物の画像なのか、偽物の画像なのかを判定するように動きます。つまり、画像を生成するためのニューラルネットワークと、画像を識別するためのニューラルネットワークが、相互にトレーニングし合うという方式が提案されています。

――様々な種類のニューラルネットワークが開発されていて、自動運転車にもその技術が搭載されていくことになるのでしょうか。

[室河氏]人は自動車を運転するとき、交通標識や路面の状況、周囲の交通の状況を、自然に意識して運転しています。実は無意識のうちに膨大な情報を処理しているわけなのですが、AIで制御する自動運転車を実現するためには、非常に多くの画像データを処理する必要があります。歩行者や自転車と接触する可能性がある一般道を走行するようなケースでは、なおさらです。

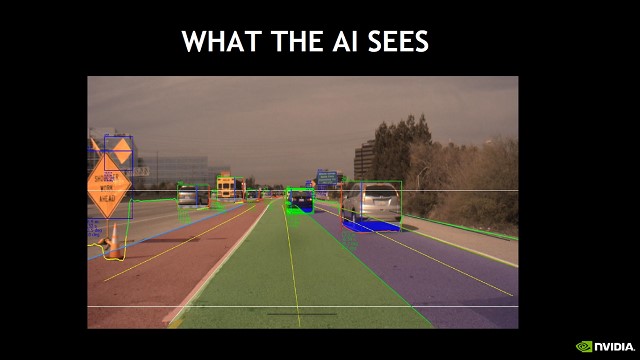

自動運転では、走行レーンや道路標識、前走車、停止車両など、カメラがとらえた入力画像をリアルタイムで認識処理する必要がある。

[室河氏]人間は常に五感を使って外界からデータを取り込み、認識し、その意味を理解して対応しています。例えば、高速道路で自動車を運転する場合、走行車線にいるのか、追越車線にいるのか、自車が遵守しなければならない道路標識はどれか、左から合流してくるトラックがあるとか、前方に交通渋滞があるなど、即応性が必要な状況が刻々と現れます。

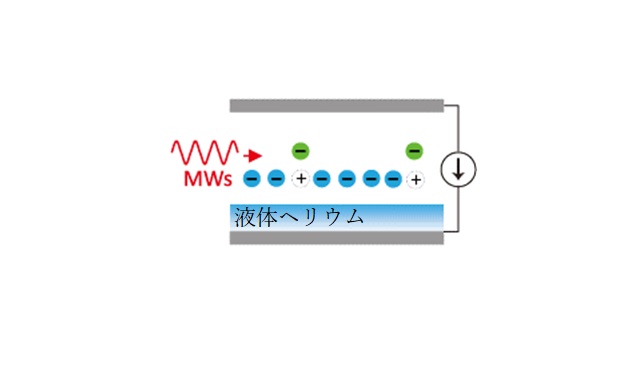

人間が状況を認識して、それに対応しているように、外界の状況に応じて関連する知識を引き出す能力が、安全な自動運転車両を実現するための柱になります。カメラやセンサーが取得する外界からの入力は大量かつ複雑で、その中から安全運転に必要な情報を選別するためには、並列に機能するDNN(Deep Neural Network)間の連携が必要になります。新しいAIであるDNNのアルゴリズムは、人間の脳からヒントを得た数学モデルで、経験から学習することができます。このDNNを認識に関わる構成要素の中核としています。

――一つの多機能なソフトウェアではなく、学習機能を持ち、機能モジュールのように細分化されたネットワーク、DNNが連携し、全体として自動運転機能を実現しているということでしょうか?

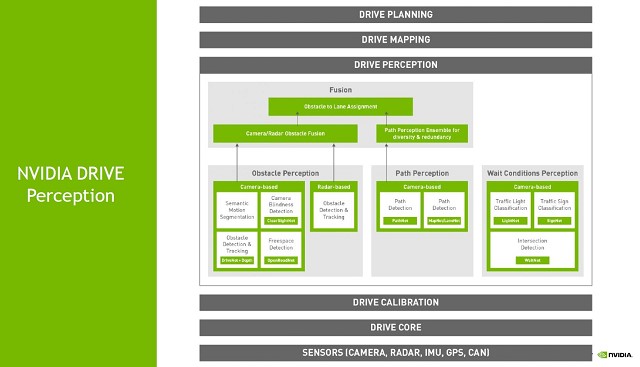

[室河氏]弊社は自動運転車の開発プラットフォームとして、「NVIDIA DRIVE」を提供しています。その主要コンポ―ネントであるソフトウェアスタックは、包括的な認識機能を実現するため、必要なDNNを連携させるためのライブラリやフレームワーク、ソフトウェアパッケージなどから構成されています。

自動運転を実現するため、障害物検知や信号検知など、機能ごとのDNNがあり、一つのパッケージとして連携し、包括的な制御機能を提供している。

ネットワークを多重化することで、安全性を担保する

[室河氏]この自動運転車のパッケージでは、他の自動車や歩行者などの障害物を検出し、対象までの距離をリアルタイムに計算する「DriveNet」、運転可能な場所を検出する「OpenRoadNet」、走行レーン情報を検出し、境界を認識する「LaneNet」、運転可能な経路を検出する「PilotNet」などによって、自車が進むべき通路、走行可能な経路が決定されます。

それに、道路上には走るだけでなく、交差点や信号、交通標識といった待機条件が示されています。これについては、「WaitNet」、「LightNet」、「SignNet」といったDNNを組み合わせて待機状態を認識します。また自動運転には欠かせないカメラの光学部分について、「ClearSightNet」というDNNがバックグラウンドで稼動し、カメラによる視界がクリアか、汚れなどで視界が遮られていたりしないかを評価しています。

高度な認識が必要でない物体の追跡といった特定の機能には、従来のコンピュータビジョン(CV)技術を使っています。このように、DNNベースとCVベースの両方を同時に使いながら、複数のカメラで周囲を認識し、車両周辺の全方位をカバーしています。

多様なDNNを同時に実行し、オーバーラップしながら多重性、冗長性を提供することが、安全性を担保する重要な要素となります。

この考え方は大切で、自動運転車が搭載する様々なセンサー、カメラやレーダーなども一つではなく、方式の違うセンサーを組み合わせたセンシングが非常に重要と考えています。

――ソフトウェア、ハードウェアの両面から自動運転を開発しているわけですね。このまま製品化できるようにも感じられます。

レベル2+の自動運転を実現するリファレンスアーキテクチャ「DRIVE Hyperion」。多様なセンサーを組み合わせたセンシングを提供する。

[室河氏]自動運転向けに、GPUやAIを使った技術をどんどん投入していこうと考えています。車両のコントロールユニットそのものを販売することはしませんが、半導体メーカーとしてSoC(System-on-a-chip)を開発するため、そして自動運転を理解するために開発用車両を持っています。

――国内の自動車メーカー、例えば日産のプロパイロットやSUBARUのアイサイトのように、センシングはカメラだったり、ミリ波レーダーだったり、メーカーやサプライヤごとに個性というか特徴があるように思います。

[室河氏]NVIDIAは、レベル2+の自動運転機能を備えたアーキテクチャ「DRIVE Hyperion」

を開発しました。こちらはセンシング用として、複数のカメラとLiDAR(ライダー:パルスレーザーダイオードを使った光センサー)、ミリ波レーダや、他にも様々なセンサーを備えています。DNNもそうですが、センシングハードウェアについても多重性を持たせることが、高い安全性という観点から重要な要素だと考えています。

最終回の次回は、「自動運転開発の現状と今後」と題してお話を伺います。

室河徹(エヌビディア シニアソリューションアーキテクト)

1992年、日本テキサス・インスツルメンツ株式会社に入社、CPUやDSP、携帯電話向けSoCの製品マーケティング・技術に従事。2015年、エヌビディア合同会社に入社。自動車向けSoCに関する技術に携わっている。

取材協力先

ライタープロフィール

後藤 銀河

アメショーの銀河(♂)をこよなく愛すライター兼編集者。エンジニアのバックグラウンドを生かし、国内外のニュース記事を中心に誰が読んでもわかりやすい文章を書けるよう、日々奮闘中。