電気通信大学は2024年3月11日、同大学と東京電機大学との研究グループが、操作者の表情を表現でき、同時にその場の映像や音響を操作者に伝えることができる、遠隔操作型アンドロイドアバターを開発したと発表した。

これまで視覚情報や操作性に焦点を当てた遠隔操作型ロボットや、人に近い見た目やふるまいによって人とのコミュニケーションを円滑にするようなアンドロイドに関する研究が行われてきた。しかし、操作性などの操作者側の利便性と、対面者とのコミュニケーションの双方を同時に向上させるような発想のシステム開発などは行われてこなかった。

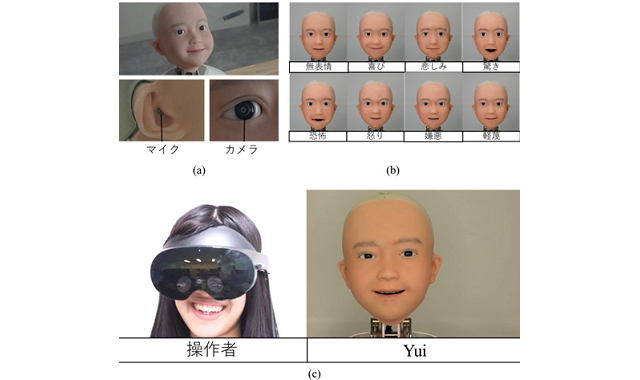

今回の研究では、人に近い見た目を持つアンドロイドアバター「Yui」を開発。頭部型の同アバターは、28カ所が変形/動作し、喜怒哀楽の表情を表現できる。また、両目、両耳部分にステレオカメラとステレオマイクを内蔵。同アバターがいる場所の映像と音声を取得し、VRヘッドセットを通じて操作者へ届けられる。VRヘッドセットは立体映像および立体音響に対応しており、どの方向からの音声かが認識できる。

VRヘッドセットには操作者の頭部の回転や顔の各部位の変化を取得するセンサーを搭載。表情などを同期させながら、マイクによってアバターと対面する人物と対話することができる。

動作検証を実施した結果、操作者の笑顔や目元の動きがアバター上で再現されることで、対面者が操作者の存在感を得ることが可能なことが示された。また、ステレオカメラとステレオマイクによる立体情報を操作者が取得することで、操作者がまるでその場にいるような臨場感を得ることが期待されるという。

関連情報

【ニュースリリース】操作者が”憑依”できるアンドロイドアバターを開発―視聴覚の共有による臨場感と操作者の表情再現による存在感を両立―│電気通信大学